上次寫那篇主要是因為 AI 出錯, 引發了我想記錄下來的興趣. 但後來看到一些類題需要腦筋再多轉幾個彎. 我還是做個筆記才好複習.

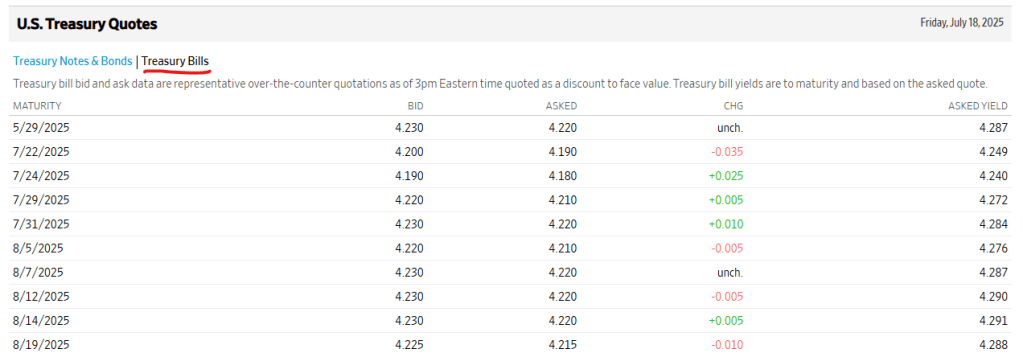

Q1, 有個 T-Bills 用 99,900 買了, 還有 180 天到期. yield to maturity 是多少?

上回講到計算隱含價值, 這回我買都買了, 狀況就不一樣. 所以不是用那個公式, 倒是可以用直覺.

由於 180 天後我可以拿到 100,000 元, 表示我可以賺 100,000 – 99,900 = 100 (元).

獲利率 = 100/99,900, 後續可以當作 Annual Payment Rate = APR 來計算.

年化 yield to maturity = 100/99,900 x (360/180) = 0.2002%

Q2. EAR 是多少?

Effective Annual Rate = EAR = (1 + APR/m)m , 本例子中, 我剛好買在生命周期的一半, 故兩個半年相當於兩期, m = 2.

EAR = (1 + 0.1001%)360/180 – 1 = 0.2003%

這明顯是一個買貴的例子. 但注意 EAR 只會比 yield to maturity 大一點點. 如果數量級差太多就是算錯了.

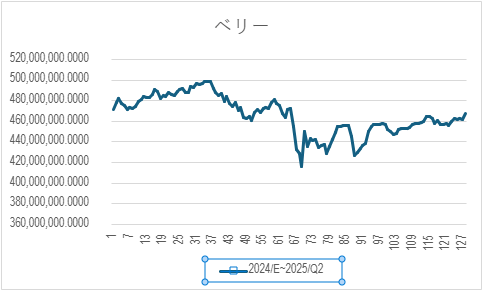

Q3. 隔夜逆回購 (ON RRP = Over Night Reverse Repurchase)

A 銀行在美聯儲的存款帳戶(reserve account)有閒置的 10 億美金, 向美聯儲申請參與 ON RRP, 假設隔夜逆回購利率 5.8%, 1 天能賺到多少錢?

美聯儲接受 ON RRP 申請後, 銀行將指示美聯儲從自己在聯儲的帳戶扣款 (減少 reserve balance), 當作國債的抵押品. 銀行則得到國債一紙.

第二天, 美聯儲把錢還給銀行, 並且支付國債利息 10億美元 * 5.80% * (1/360) ≒ 16.11 萬美元. A 銀行把國債還給美聯儲.

假設匯率 1 USD = 29.49, TWD, 16.11 萬美元 = 475.1 萬元台幣.

參考 [1], 銀行不勞而獲的結果, 剛好可以養一個螃蟹工程師 (對, 數字我湊的). 我的重點是, 錢每天都在貶值, 你怎麼可以不投資?

[REF]