這本書 [1] 很難摘要,因為它的內容就長得像摘要過的樣子,只有短短的 82 頁。作者不是納瓦爾‧拉維肯 (Naval Ravikant) 本人,而是艾瑞克‧喬根森 (Eric Jorgenson) 。前者是創投家,後者是理財部落客。也就是納瓦爾述而不作,由艾瑞克集註。

如果要從這些摘要中再摘要一次,確實很不容易。我只能把我印象最深刻的東西寫下來。

做自己喜歡的事,就不只是單純的工作。別人很難在這種情況下還贏過你。

無論是財富的累積或是其他方面,都可以用槓桿觀念和時間複利來擴大自己的成就。槓桿有三種。

- 人力槓桿 – 當大老闆,叫其他人做事。雖然很有面子,但效率最低的。

- 資本槓桿 – 財務遊戲,用錢賺錢。

- 零邊際成本槓桿 – 用書籍、媒體、影片、軟體賺錢。透過低成本的複製,達到最大的效果。

複利對財富、個人專業和品牌都適用。例如百年老店比十年"老"店厲害不只十倍。

有三種方式可以達到退休目標:

- [邏輯上] 讓被動收入大於花錢的速度。

- [理性上] 降低物慾,就像 «跟錢好好相處» 裡面說的。

- [感性上] 做喜歡的事,樂在其中,錢就不重要了。

幸運有四種:

- 矇到的。

- 堅持努力,為自己創造出機會。

- 透過專精於某個領域,主動創造出發現幸運的機會。

- 打造出獨一無二的性格、品牌、和心態,讓幸運自己找到你。舉例來說,前幾天攀登上 101 的 Alex Honnold 就是被 Netflix 選上的那個人。

委託 – 代理問題 (principal-agent problem):

如果你希望一件事成功,不是自己做就是委託另一個人全權負責。相對地,代理人並沒有雙向的長期承諾,自然就不會那麼重視成敗。公司愈小,成員就愈像委託人。

納瓦爾說在高科技時代,如果你具有別人沒有的能力,人家當然要花錢請你。銷售也是,有些人就是比別人更會賣東西。如果同時具備這兩種能力就無敵了。有 AI 之後,情況稍微有點改變。但是天才工程師,還是比號稱工程師和 AI 更搭。

創造財富是正和賽局,追求權力是零和賽局。財富能帶來自由,但不等於智慧。

判斷力的重要性常被低估,努力則常被高估。判斷力是解決問題的智慧。作者的意思應該是指成功像是一種向量,判斷力決定出正確的方向後,接著努力使用槓桿去舉起目標。當你做決定的時候,要制服心中的不會思考、只有衝動的猴子 – 心猿 (mind monkey, p.38)。

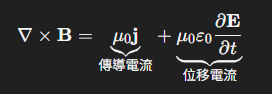

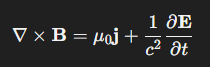

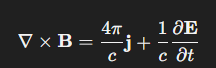

在本書四十幾頁以後,呈現一種老生常談,算是本書的低谷區。書上告訴大家 “不要太自信、要誠實、不要預設立場…"。"沒有實際經驗的名言只是酷,學習聰明人的心智模式才重要。"簡單地說,不要管欣梅爾說了什麼? 只要知道欣梅爾會怎麼做? [2] 接著是用三言兩語說演化論、複雜理論 (Complexity Theory) [3]、經濟學、複利、基礎數學、黑天鵝、微積分、可否證性 (falsiability) 都重要。多讀書可以建立新的心智模式。

後面幾頁同樣地迷。"如果無法決定,答案就是否定"、"如果有兩個選擇,就選短期比較苦的"、"懂邏輯和數學就可以看懂所有書"、"讀書不在多、而在於愛讀書"。在這些金句之後,本書就完成了第一部 “關於致富"。老實說,我覺得收尾得很飄。

第二部 “關於快樂"。納瓦爾說快樂就是覺得自己什麼都不缺。我們不能改變世界,但是可以塑造自己。所以接受事實、找回平靜、選擇快樂。快樂不是靠達成目標 (p. 49)。快樂是對自己擁有的感到滿足、成功則是來自於不滿足 (p.51)。人生不管遇到什麼困難,只有三個選擇:改變它、接受它、或是擺脫它 (p.53)。

下一章講得比較入世,主要是說健康要擺第一、要學原始人、生酮飲食、運動、冥想、建立好習慣、主動學習新知、忠於自己、不要退縮、免於憤怒、免於受雇 (p.64)、免於不受控。其中只有免於受雇的自由讓人眼睛一亮,因為他們更喜歡創業,哈!

第五章講納瓦爾的價值觀和他認為人生的意義。生命的意義可能有三個:(1) 因人而異、(2) 沒有意義也沒有目的、(3) 熱力學第二定律 [5]。嗯…所以只能活在當下 (p. 67)。再來就是納瓦爾推薦的書、部落格、推特。然後是作者補充納瓦爾的相關資料和註釋等等。

對於我而言,我感覺到納瓦爾是個聰明人,這些從本書第一部就可以感受得出來。他對於財富的理解很有一套。他沒有給我們魚、沒有教我們釣魚、而是跟我們說不一定非要吃海鮮不可,吃素也會飽;更取決幾分飽叫做飽? 甚至 “一簞食一瓢飲,回也不改其樂" [6]。

至於講到快樂的部分,我覺得書中的觀點有點佛化了。面對它 = 接受它、處理它 = 改變它、放下它 = 擺脫它。納瓦爾說我們面對困難只能選擇一種,證嚴上人三招可以全部都用上。要講人生智慧,矽谷大亨不可能說得過宗教家啦! 不過有智慧的富人還是比較難能可貴就是了。

[REF]

- 納瓦爾寶典: 從白手起家到財務自由, 矽谷傳奇創投家的投資哲學與人生智慧 (The Almanack of Naval Ravikant: A Guide to Wealth and Happiness)

- 成句/如果是勇者欣梅爾的話一定會這麼做的

- 複雜理論

- 可證偽性

- 在一個孤立系統中,總熵(無序程度)永遠趨向增加,不可逆地從有序走向無序,這決定了物理過程的不可逆性與時間方向

- 論語雍也第九篇