前陣子發現, 網路上不只是有很多學習資源, 而且好幾個單位都證書. 雖然這些證書把關通常很鬆散, 但是用來記錄自己學了什麼就很有幫助. 換個角度看, 畢竟我們不是被逼著上課, 已經知道的或重複的就可以跳過. 而不是像在學校裡, 不能因為聽懂就翹課或是不參加考試, 那就畢不了業了.

如果說 AI 有哪個東西要先學習, 我看起來還是 Python. 然後搭配自己的專業領域使用. 像是 audio, video, image, 或者是我以前用在 OCR. 新手可以學 Python 的地方超級多, 入門也非常簡單. 所以這應該是正確的第一步無誤. 再來介紹一下錯誤的第一步.

有些人, 像是我, 從小就對人腦很有興趣. 總是會想要用人腦的特性來做出更厲害的 AI. 比方說, 有一天我想到遺忘也是人的特性, 如果讓神經網路可以遺忘, 不就是一大突破了! 哇哈哈哈…不過我很快就發現 LSTM (Long Short-Term Memory) 已經有這招了! 我又想到, 意義相似的字應該用向量表示遠近比較好! 再一查, word embedding 已經有向量觀念….嗯, 我想得到人家也想得到.

我記錄 idea 的 Onenote 筆記

所以專家幾乎都不推薦用人腦去設計 NN. 頂多是在投影片裡, 從生醫角度切入, 使人覺得更高大上 (e.g. BERT 用上 DNA 雙螺旋來講解). 除非你就是要複製人腦, 不在乎它到底能不能實用 (make money)! 至於聽起來就沒有商機則是例外. 像是 hypothalamic-pituitary-adrenal axis [6] 和 AI 的關係就只限於 A drenal I nsufficiency (腎上腺機能不全), 表示未來讓 AI 談戀愛這個領域還有發展空間.

言歸正傳. 有了語言, 接下來要找環境. 以前我傻傻地自己開 Jupyter Notebook, 後來發現 Google Colabatory 就能直接用了. 除非需要很大的算力時, 才需要用到自己 PC 的顯卡. 若只是要練習 Python, 學 AI, 直接註冊一個免費的 Colab 帳號即可, 而且很多 Google 的網路資源都可以直接調用. 不用到處找. Colab 不開 GPU/TPU 時, 預設在 no power 等級. 設定裡面可以選柯基犬、貓咪、螃蟹模式, 我還以為有什麼差別, 原來是小動物跑來跑去~~

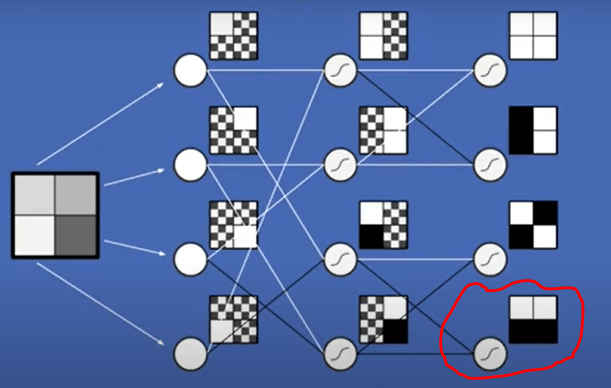

接下來, 我認為值得按讚是 CNN. 因為除了 CNN, 很多背景知識都跟我 30 年前學的差不多. (當然我那個時候講到 CNN, 一定是先想到 Concurrent 開頭的 CNN, 不是現在 Convolution 開頭的這個 CNN). 會強調 CNN, 主要是 CNN + DNN (deep learning) 把特徵值和絕對位置脫鉤了. 這個真的很厲害.

新 model 可以留給博士們研究, 要實做就需要學 framework. Google 主推的 tensorflow [3] 有許多教學網站. 除了 Youtube 上非常多老師在教. FreeCodeCamp [2] 也 “免費" 教很多技術, 他們在介紹 AI 相關技術時也會用到 tensorflow + Colab, 我覺得挺不錯. 其中, 講解的小哥可以快速講一些基本觀念. 當然他們沒辦法一行一行 trace code, 或是把細節講得很清楚. 講師帶我們瀏覽完大概, 細節就要自己花時間看, 最好是 Colab 開起來模擬一遍.

在 Youtube 也可以找到 FreeCodeCamp 小哥 Tim 的 7 小時學 tensorflow. 然而, 連復仇者終局之戰都沒演那麼久了, 誰能一口氣看得完這個? 所幸在 FreeCodeCamp 上, 這個影片會被分成大約每 15 分鐘一段的短片, 每個短片後面還有一個小測驗, 算是滿貼心的設計. 這樣就不需要太考驗耐心.

然而, FreeCodeCamp 不是 Google 這種大戶, 所以它需要大家自願 donate 才活得下去 (5 USD 起跳, 每個月捐 20 USD 可以讓其他人學習 1 千小時.). 畢竟 lib 或是 tool 會過時, 隔一陣子確實該更新或 debug. 像是 tensorflow 小哥影片中的 sklearn 已經可以改用新版的 scikit-learn, 或者講 DNN 的老哥在 7’51″ 這個地方線的顏色有些不對, 按圖 negative * negative 應該是 positive, 後續影片播到 10’10″ 左右這兩條線才更正為 positive. 總之, 他們值得贊助, 也需要贊助.

至於要學另一個主流 framework 是 Pytorch, 教學影片除了 Youtube, 就只找到 Microsoft [4]. Pytorch 當初是 Meta 推的, 不過 Meta 好像跟 Google, Microsoft (OpenAI) 的發展沒得比. 但是看在開源 llama2 的份上, 我對 Meta 感激不盡, 也原諒它一直偷聽我講話.

基於我們不會大改 model, 用 LoRA (Low-Rank Adaptation) [5] 可以小改. LoRA 訴求主要是在某幾層針對特定目標減少計算. 更小的修改是直接在既有模型後面再加一層 (或許幾層也是可以), 把原本的結果從新詮釋. FreeCodeCamp 的例子是從原本能分辨 10 種動物的模型, 改為只要能認貓或狗. 當然這沒省到計算量, 但是可以揀現成.

[REF]

https://colab.research.google.com/

https://www.freecodecamp.org/ https://www.tensorflow.org/?hl=zh-tw https://learn.microsoft.com/zh-tw/shows/ai-show/pytorch-deep-dive https://d223302.github.io/AACL2022-Pretrain-Language-Model-Tutorial/lecture_material/AACL_2022_tutorial_PLMs.pdf https://www.ncbi.nlm.nih.gov/pmc/articles/PMC3181830/