3D BD 的 video 的壓縮格式是 H.264 的附錄 H, 也就是 H.264 MVC (Multi-view Video Coding).

為了和傳統的 2D 電視相容, 有一個主視頻碼流專門放左眼或是右眼的訊號, 另外再用一個輔助視頻碼流來儲存擴展的資訊.

輔視頻流採用了 inter-view prediction 的方式, 也就是左右眼可以互相預測. 這使得輔視頻流的碼率可以降到主視頻流的一半左右.

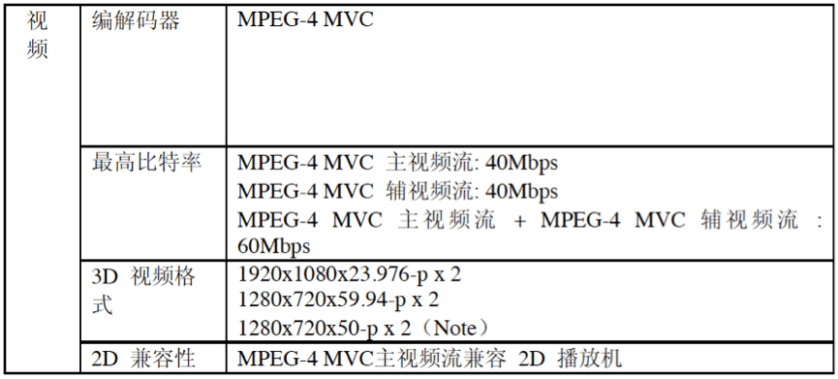

Note: 50 Hz 系統用於歐洲. (本圖取材自藍光白皮書)

從上表可以看到 3D 光碟裡面會有哪些 bit stream? 有趣的地方是, 為什麼有一個主視頻流, 一個輔視頻流, 又有一個主視頻流+輔視頻流呢?不能簡化一點嗎?

事實上, 它們只是表達方式的不同. 一個表示成主輔兩個碼流 (附檔名 m2ts, stream 目錄下), 另一個表示為混合的單一碼流 (附檔名 ssif, steam\ssif 目錄下).

網路上有人反應他的 BD 光碟中, m2ts 和 ssif 文件的大小加起來竟然比一片 BD 的容量更大!就是被 file system 給騙了. 其實, 文件實體在 m2ts, ssif 只是 m2ts 的鏡像. Data 只有一份.

SSIF 是 Stereoscopic interleaved file 的縮寫. 它交錯地把主輔視頻切成小段存放. 在3D 播放時, 就直接讀取整個 bit stream. 2D 播放時, 只要根據索引適時跳過輔助碼流的部份, 就可以選擇性地播出主視頻流, 達到與 2D 電視相容的效果.

另外, 網路上有些破解教學, 教大家如何用主視頻流和輔視頻流的 m2ts, 生出左右眼完整的兩個 bit stream. 然後再用 tool 做成 Frame Sequential 的方式 (左一張, 右一張), 或者品質差一點, 做成 side-by-side 或是 top-bottom. 如此一來, 就算 player 看不懂 SSIF, 也都播得出 3D.

呃, 壞的不要學, 知道原理就好.

看來賣 3D 眼鏡或 TV, 還是比賣 3D BD 保險. 至少沒有人在破解眼鏡…

[ref]

1. 英语的藍光白皮書

2. 家用3D视频格式(一)数据存储格式